1.2. Yapay Zekânın Evrimi: Kavramdan Devrime

Şekil 1.8. Yapay Zekânın Evrimi.

Şekil 1.8. Yapay Zekânın Evrimi.

Not. Dijital Eğitim Koordinatörlüğü. Creative Commons Lisansı (CC BY NC-ND).

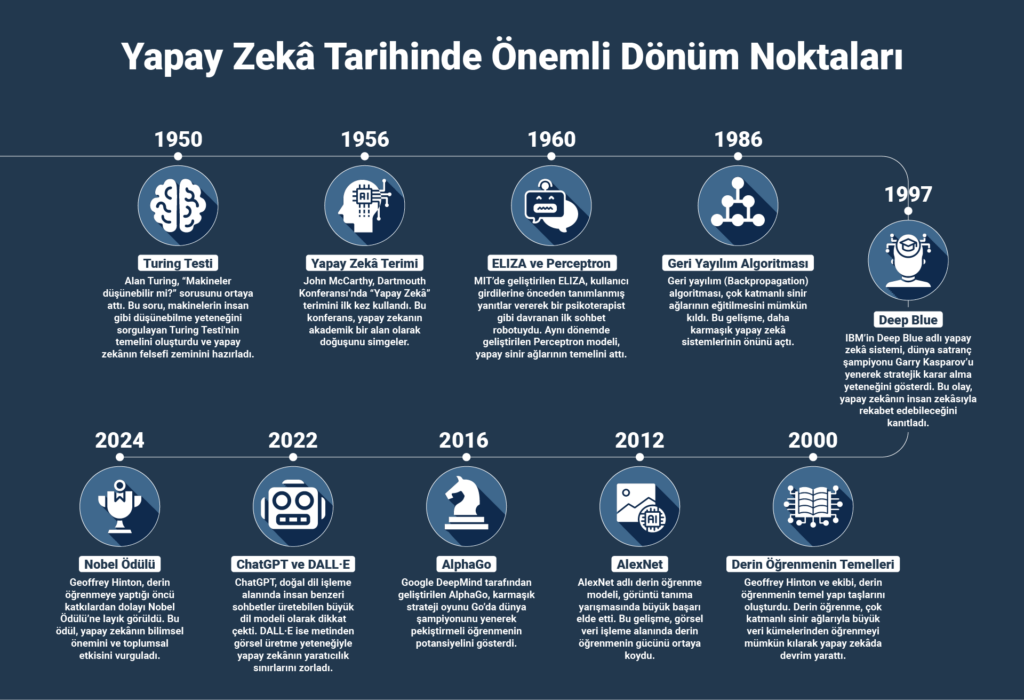

Yapay zekâ, günümüzdeki kadar popüler ve etkili olmadan önce uzun ve karmaşık bir evrim sürecinden geçmiştir. YZ’nin tarihi, yalnızca teknolojik ilerlemelerle değil; aynı zamanda felsefi tartışmalar, bilimsel atılımlar ve toplumsal beklentilerle de şekillenmiştir. Bu bölüm, yapay zekâ fikrinin doğuşundan bugünkü “patlama” noktasına nasıl gelindiğini kronolojik olarak incelemektedir. YZ’nin kökenlerini, önemli dönüm noktalarını, başarılarını ve karşılaştığı zorlukları anlamak; günümüz yapay zekâsının potansiyelini ve gelecekteki yönünü kavramak açısından büyük önem taşır.

Erken Dönemler (1950’ler-1960’lar): Öncü Fikirler ve İlk Adımlar

Yapay zekâ kavramının kökeni, otomasyon ve mantık üzerine yapılan antik tartışmalara kadar uzansa da; modern anlamda bir bilim dalı olarak 20. yüzyılın ortalarında şekillenmeye başlamıştır. Bu dönem, bilgisayar bilimcileri ve matematikçilerin makinelerin “düşünebilir” olup olamayacağı üzerine spekülasyon yaptığı ve ilk somut adımların atıldığı zamandır. II. Dünya Savaşı’nın ardından hızla gelişen bilgisayar teknolojisi, bu felsefi tartışmaların somut projelere dönüşmesi için uygun bir zemin hazırlamıştır.

Yapay Zekâ Teriminin Ortaya Çıkışı ve Dartmouth Konferansı

Modern yapay zekâ alanının doğum noktası olarak kabul edilen olay, 1956 yazında New Hampshire’daki Dartmouth College’da düzenlenen Dartmouth Yaz Araştırma Projesi’dir. Bilgisayar bilimcisi John McCarthy, bu konferansın teklifinde “Artificial Intelligence” (Yapay Zekâ) terimini ilk kez kullanarak, makinelerin insan zekâsını taklit etme fikrini bilimsel bir disiplin olarak adlandırmıştır.

Konferans, makine öğrenmesi, doğal dil işleme, sinir ağları ve soyutlama gibi yapay zekânın temel konularını tartışmak üzere dönemin önde gelen araştırmacılarını — John McCarthy, Marvin Minsky, Nathaniel Rochester, Claude Shannon, Allen Newell, Herbert A. Simon gibi isimleri — bir araya getirmiştir.

Bu toplantı, YZ’yi bağımsız bir araştırma alanı olarak resmen tanımlamış ve gelecekteki çalışmalar için bir yol haritası sunarak alanın gelişiminin önünü açmıştır.

Konferansın temel varsayımı şuydu: “Öğrenmenin veya zekânın diğer herhangi bir özelliği, prensipte o kadar açık bir şekilde tanımlanabilir ki, bir makine bu özelliği simüle edecek şekilde programlanabilir.”

Şekil 1.9. Yapay Zekânın Gelişim Dönemleri.

Şekil 1.9. Yapay Zekânın Gelişim Dönemleri.

Not. Dijital Eğitim Koordinatörlüğü. Creative Commons Lisansı (CC BY NC-ND)

Alan Turing ve “Makineler Düşünebilir mi?” Sorusu (Turing Testi)

Yapay zekâ alanının felsefi ve teorik temelleri, İngiliz matematikçi ve bilgisayar biliminin öncülerinden biri olan Alan Turing’in çalışmalarıyla atılmıştır. II. Dünya Savaşı’nda Enigma kodunu çözmesiyle tanınan Turing, 1950 yılında yayımladığı “Computing Machinery and Intelligence” (Bilgisayar Makineleri ve Zekâ) başlıklı makalesinde, “Makineler düşünebilir mi?” sorusunu ortaya atmıştır. Bu temel soru, makinelerin insan zekâsını ikna edici biçimde taklit edip edemeyeceğini değerlendirmeye yönelik olan Turing Testi’nin de temelini oluşturmuştur.

Turing Testi’nde, bir insan sorgulayıcı (hakem), yalnızca yazılı iletişim yoluyla hem bir insan hem de bir makineyle konuşur ve hangisinin insan olduğunu ayırt etmeye çalışır. Eğer sorgulayıcı, yeterli sayıda denemeden sonra makineyi insandan ayırt edemezse, makinenin zekâ sahibi olduğu kabul edilir.

Bu çalışma, insan benzeri problem çözme, mantık yürütme ve doğal dil anlama yetilerini araştıran bir alanın doğmasına katkıda bulunmuş ve yapay zekânın teorik çerçevesini oluşturmuştur.

Kural Tabanlı Sistemler ve İlk Başarılar

Yapay zekânın ilk dönem uygulamaları büyük ölçüde sembolik yaklaşımlara ve kural tabanlı sistemlere dayanıyordu. Bu sistemlerde, uzman bilgisi açık biçimde “eğer…ise” (if-then) kurallarıyla kodlanıyordu. Örneğin, bir uzman sistem, bir doktorun teşhis sürecini taklit etmek amacıyla yüzlerce veya binlerce kural içerebilmekteydi.

Bu dönemin öne çıkan örnekleri arasında MYCIN (tıbbi teşhis) ve DENDRAL (kimyasal yapı analizi) yer almaktadır. Bu sistemler, dar ve iyi tanımlanmış problem alanlarında etkili olsalar da, bilgi ediniminin zorluğu ve belirsiz durumlara genelleme yapamama gibi sınırlamalara sahipti.

ELIZA: İlk Metin Tabanlı Sohbet Robotu

1960’lı yıllarda MIT’de Joseph Weizenbaum tarafından geliştirilen ELIZA, metin tabanlı ilk sohbet robotlarından biridir. ELIZA, kullanıcı ifadelerini basit anahtar kelime eşleştirmeleriyle analiz edip önceden tanımlanmış kalıplarla yanıt vererek Rogerian terapi tarzında bir psikoterapisti taklit etmiştir. Örneğin, kullanıcı “Kocamla sorunlarım var” dediğinde, ELIZA “Kocanızla sorunlarınız olduğunu mu düşünüyorsunuz?” şeklinde yansıtıcı bir yanıt üretebilirdi.

Anlamaktan çok yüzeysel kalıp eşleştirmeye dayansa da ELIZA, kullanıcılarla etkileşim kurma yeteneği sayesinde bir bilgisayarın insan benzeri davranışlar sergileyebileceğini göstermiştir. Bu, doğal dil işleme alanındaki erken bir dönüm noktası olmuştur.

Perceptron: Yapay Sinir Ağlarının Temelleri

1957 yılında Frank Rosenblatt tarafından geliştirilen Perceptron modeli, yapay sinir ağlarının öncüsü kabul edilir ve Makine Öğrenmesi’nin temellerinden biridir. Perceptron, insan beynindeki nöronların basit bir matematiksel modeli olarak geliştirilmiştir ve girdileri ağırlıklarla çarpıp bir aktivasyon fonksiyonundan geçirerek çıktı üretmektedir. Basit görevlerde, özellikle optik karakter tanıma gibi ikili sınıflandırma problemlerinde başarı sağlamıştır.

Ancak 1969 yılında Marvin Minsky ve Seymour Papert’in yayımladığı “Perceptrons” adlı eserlerinde, tek katmanlı Perceptron’un XOR gibi doğrusal olarak ayrılamayan problemleri çözemediği gösterilmiştir. Bu eleştiri, sinir ağı araştırmalarına olan ilgiyi azaltmış ve “Yapay Zekâ Kışı” olarak bilinen dönemin başlamasına neden olmuştur.

Erken dönem YZ sistemleri ve Perceptron gibi modeller, işlevsel sınırlamalarına rağmen, makinelerin insanlarla etkileşim kurma potansiyelini ortaya koymuş ve daha gelişmiş sistemler için bir temel oluşturmuştur.

Makine Öğrenmesi’nin Yükselişi (1980’ler-2000’ler): Temel Bir Değişim ve Veri Odaklı Yaklaşımlar

Şekil 1.10. Makine Öğrenmesinin Yükselişi.

Şekil 1.10. Makine Öğrenmesinin Yükselişi.

Not. Dijital Eğitim Koordinatörlüğü. Creative Commons Lisansı (CC BY NC-ND).

1980’lerin sonları ve 2000’li yılların başı, yapay zekânın “YZ Kışı” olarak adlandırılan durağan dönemden çıkarak, kural tabanlı programlamadan daha esnek ve güçlü bir yöntem olan makine öğrenmesine yöneldiği kritik bir evredir. Bu geçiş; algoritmik gelişmeler (özellikle geri yayılım algoritmasının yeniden keşfi), bilgi işlem kapasitesinin artması ve büyük veri kaynaklarına erişimin kolaylaşması gibi etkenlerle desteklenmiştir. Sembolik YZ yaklaşımlarının sınırlılıklarının belirginleşmesiyle birlikte, istatistiksel ve veri odaklı yöntemler ön plana çıkmıştır.

Kural Tabanlı Programlamadan Veri Odaklı Yaklaşıma Geçiş

Geleneksel kural tabanlı programlamada, bilgisayara bir görevi yerine getirmesi için adım adım ne yapması gerektiği açıkça belirtilir. Bu yaklaşım, her durum için önceden tanımlanmış kurallar yazılmasını zorunlu kılar. Ancak, bu tür sistemler belirsiz ve dinamik gerçek dünya problemleri karşısında yetersiz kalmıştır.

Makine öğrenmesi ise bu yapıyı terk ederek, bilgisayara veri üzerinden öğrenme kabiliyeti kazandırmayı hedefler. Bu yeni yaklaşım, sistemlerin verilerdeki örüntüleri kendiliğinden keşfetmesini, genellemeler yapmasını ve daha önce karşılaşmadığı durumlara uyum sağlamasını mümkün kılar. Böylece, katı kurallar yerine “öğrenen makineler” fikri ön plana çıkmış ve yapay zekânın uygulama alanları genişlemiştir.

Geri Yayılım Algoritmasının Yaygınlaşması ve Sinir Ağlarının Yeniden Doğuşu

Makine öğrenmesi alanındaki önemli atılımlardan biri, 1986 yılında Geoffrey Hinton, David Rumelhart ve Ronald Williams tarafından geri yayılım algoritmasının (backpropagation) popülerleştirilmesidir. Her ne kadar bu yöntem 1970’lerde de biliniyor olsa da, çok katmanlı yapay sinir ağlarının verimli biçimde eğitilmesini sağlayabileceği bu dönemde net bir şekilde gösterilmiştir.

Geri yayılım, modelin çıktısı ile beklenen değer arasındaki hatayı hesaplayarak, bu hatayı ağın katmanlarında geriye doğru yayar ve bağlantı ağırlıklarını hatayı minimize edecek şekilde günceller. Bu mekanizma, sinir ağlarının öğrenme sürecini optimize eder ve daha karmaşık problemlerin üstesinden gelmelerini sağlar. Geri yayılımın etkinliği, sinir ağlarına olan ilgiyi yeniden canlandırarak bu alanın “rönesansını” başlatmıştır.

Deep Blue’nun Kasparov’u Yenmesi

1997 yılında IBM tarafından geliştirilen Deep Blue adlı yapay zekâ sistemi, dünya satranç şampiyonu Garry Kasparov’u yenerek yapay zekânın stratejik düşünme kapasitesini dünya çapında kanıtlamıştır. Deep Blue, özel donanımlar sayesinde saniyede 200 milyon hamle analiz edebilen, büyük ölçüde kaba kuvvet arama ve derin pozisyon değerlendirme teknikleriyle çalışan bir sistemdi. Bu başarı, yapay zekânın kapalı ve iyi tanımlanmış problem alanlarında insan performansını geçebileceğini göstermiştir. Olay, kamuoyunun ve bilim çevrelerinin YZ’ye olan ilgisini yeniden canlandırmıştır.

Derin Öğrenmenin Temelleri

2000’li yıllarda Geoffrey Hinton, Yann LeCun ve Yoshua Bengio’nun öncülüğünde derin öğrenme araştırmaları yeniden önem kazanmıştır. Bu dönemde geliştirilen çalışmalar, çok katmanlı yapay sinir ağlarının, büyük veri setleri ve artan işlem gücü ile nasıl etkili biçimde eğitilebileceğini ortaya koymuştur. Özellikle ImageNet gibi geniş çaplı etiketli veri kümeleriyle yürütülen projeler, derin öğrenmenin uygulama gücünü açıkça göstermiştir.

Derin öğrenme, birçok gizli katmandan oluşan sinir ağları sayesinde büyük veri üzerinde öğrenme yapılmasına imkân tanır. Bu yaklaşım, 2010’lu yıllarda yapay zekâ alanının yeniden doğuşunun temelini atmıştır. Geoffrey Hinton, bu alandaki öncü katkılarından ötürü 2024 yılında Kanada’da “Teknoloji Nobel’i” olarak bilinen Killam Ödülü’ne layık görülmüştür.

Makine Öğrenmesinin Genişlemesi

Makine öğrenmesi, katı programlama paradigmalarından uzaklaşarak, öğrenen ve uyum sağlayan sistemlerin gelişimine olanak tanımıştır. Bu süreçte, sadece sinir ağları değil, Destek Vektör Makineleri (SVM) ve Bayes Ağları gibi diğer önemli algoritmalar da geliştirilmiş ve çok çeşitli uygulama alanlarında kullanılmıştır.

Şekil 1.11. Yapay Zekâ Tarihinde Önemli Dönüm Noktaları.

Not. Dijital Eğitim Koordinatörlüğü. Creative Commons Lisansı (CC BY NC-ND).

Modern Yapay Zekâ Patlaması (2010’lar ve Sonrası): Derin Öğrenme ve Ötesi

2010’lu yıllar ve sonrası, yapay zekâda eşi görülmemiş bir inovasyon ve benimseme dönemini başlatmıştır. Bu “patlama” dönemi, üç temel faktörün mükemmel birleşimiyle tetiklenmiştir: büyük veri setlerinin mevcudiyeti, gelişmiş algoritmaların keşfi ve olgunlaşması ve güçlü bilgi işlem gücüne (özellikle GPU’lara) erişilebilirlik ile maliyetin düşmesi. Bu faktörlerin bir araya gelmesi, YZ’nin karmaşık gerçek dünya problemlerini çözme kapasitesini katlanarak artırmış ve yapay zekâyı laboratuvar ortamından çıkarıp günlük hayatımıza entegre etmiştir.

Güçlü Donanımın Rolü: GPU’lar (Graphics Processing Unit) ve Diğer Hızlandırıcılar: Yapay zekâ, özellikle derin öğrenme, yoğun matematiksel hesaplamalar ve paralel işlem gücü gerektirir. Geleneksel CPU’lar (Merkezi İşlem Birimleri) bu tür paralel işlem görevleri için optimize edilmemiştir. İşte burada GPU’lar (Grafik İşleme Birimleri) devreye girer.

GPU’lar, başlangıçta video oyunları ve grafik işlemleri için tasarlanmış, binlerce küçük işlemci çekirdeğine sahip donanım bileşenleridir. Bu mimari, derin öğrenme algoritmalarının ihtiyaç duyduğu yoğun matris çarpımları ve nöral ağ katmanlarının işlenmesi için son derece uygundur. Bu sayede, derin sinir ağlarının günler veya haftalar süren eğitim süreleri saatlere, hatta dakikalara inmiş; araştırmacıların ve geliştiricilerin çok daha hızlı yineleme yapmasına ve daha büyük modellerle çalışmasına olanak tanımıştır.

Şekil 1.12. Modern Yapay Zekâ Patlaması.

Şekil 1.12. Modern Yapay Zekâ Patlaması.

Not: Dijital Eğitim Koordinatörlüğü. Creative Commons Lisansı (CC BY NC-ND).

3 trilyon doları aşan piyasa değeri ile NVIDIA şirketi, yapay zekâ ve derin öğrenme alanında GPU üretiminde lider konumdadır ve bu dönüşümün en önemli itici güçlerinden biri olmuştur. NVIDIA’nın CUDA gibi platformları, geliştiricilerin GPU’ları yapay zekâ hesaplamaları için kolayca kullanmasını sağlamıştır. Ayrıca, Google tarafından özel olarak derin öğrenme iş yükleri için geliştirilen TPU’lar (Tensor Processing Units) ve belirli yapay zekâ görevleri için optimize edilmiş ASIC’ler (Uygulamaya Özel Entegre Devreler) gibi diğer yapay zekâ hızlandırıcıları da önemli rol oynamaktadır. Bu özel donanımlar, yapay zekâ modellerinin çok daha hızlı, enerji verimli ve ölçeklenebilir biçimde eğitilmesini ve dağıtılmasını sağlamıştır.

Dönüm Noktası Başarıları ve Üretken Yapay Zekâ Çağı

Bu dönemde elde edilen bazı büyük başarılar, yapay zekânın ne kadar ilerlediğini ve neler yapabileceğini göstermiştir:

- AlexNet (2012) – Görüntü Tanımada Devrim: Kanada’daki araştırmacılar Alex Krizhevsky, Ilya Sutskever ve Geoffrey Hinton tarafından geliştirilen AlexNet, büyük ölçekli görüntü tanıma yarışması ImageNet’te (LSVRC-2012) çığır açan sonuçlar elde ederek, derin öğrenmenin görüntü işleme alanındaki muazzam potansiyelini tüm dünyaya göstermiştir. Çok katmanlı evrişimli sinir ağı (CNN) yapısıyla hata oranını %26’dan %15.3’e düşürerek, o zamana kadarki en iyi sonuçları geride bırakmıştır. Bu başarı, bilgisayar görüşü alanında bir dönüm noktası olmuş ve CNN’lerin yaygın olarak benimsenmesini sağlamıştır.

- AlphaGo (2016) – Stratejik Oyunlarda İnsan Üstünlüğünün Sonlanışı: Google DeepMind tarafından geliştirilen AlphaGo, Çinli Go dünya şampiyonu Lee Sedol’u yenerek, yapay zekânın stratejik düşünme ve karmaşık oyunlarda insanları alt etme yeteneğini göstermiştir. Go, satranca göre çok daha fazla olası hamleye sahip, derin strateji ve sezgi gerektiren karmaşık bir tahta oyunudur. AlphaGo, pekiştirmeli öğrenme ve derin sinir ağlarını birleştirerek oyun kurallarını kendisi öğrenmiş ve insan uzmanlığını aşan stratejiler geliştirmiştir. Bu zafer, yapay zekânın sezgisel ve yaratıcı düşünme gerektiren alanlarda da başarılı olabileceğini göstermiştir.

- Büyük Dil Modelleri (LLM’ler) ve Üretken Yapay Zekâ: 2022 yılında OpenAI’ın ChatGPT gibi büyük dil modelleri ve DALL·E gibi metinden görüntü oluşturma araçlarının piyasaya sürülmesiyle yapay zekâ, geniş kitlelere ulaşmış ve yeni bir “Üretken YZ” çağı başlamıştır. Üretken yapay zekâ sistemleri, mevcut verilerden öğrenerek yeni ve özgün içerikler (metin, görsel, ses, video) üretebilmektedir.

- ChatGPT: Doğal dil işleme alanında devrim yaratan ChatGPT gibi modeller, milyarlarca kelimelik metin üzerinde eğitilerek insan benzeri içerikler üretebilir; soruları yanıtlayabilir, özet çıkarabilir, çeviri yapabilir, kod yazabilir ve yaratıcı metinler oluşturabilir. Bu sayede makineler, karmaşık diyalogları sürdürebilmekte ve geniş bilgiye dayalı etkileşimler gerçekleştirebilmektedir.

- DALL·E ve Benzeri Modeller: Bu araçlar, metin açıklamalarına dayanarak saniyeler içinde yüksek kaliteli ve sanatsal görseller oluşturabilmektedir. Bu gelişmeler, insan yaratıcılığı ile makine üretkenliği arasındaki sınırları yeniden tanımlamıştır.

Yapay zekânın evrimi, insanın düşünme, öğrenme ve yenilik yaratma arzusunun temelinde bir keşif yolculuğudur. Yapay zeka geliştikçe; endüstrileri yeniden tanımlayacak, bireyleri güçlendirecek ve “zekâ” kavramına dair anlayışımızı yeniden şekillendirecektir. Alan Turing’e ilham veren “Makineler düşünebilir mi?” sorusu, bugün “Makineler ve insanlar birlikte nasıl düşünecek?” sorusuna dönüşmüştür. Bu soru, yapay zekânın sadece bir araç değil, insanlığın bir ortağı olma potansiyelini vurgulamaktadır.

Yapay zekânın geleceği, insan-makine işbirliğinin yeni ve karmaşık biçimlerini keşfetme vaadi taşımaktadır. Bu işbirliği, daha önce hayal bile edilemeyen çözümler ve inovasyonlar üretme potansiyeline sahiptir.